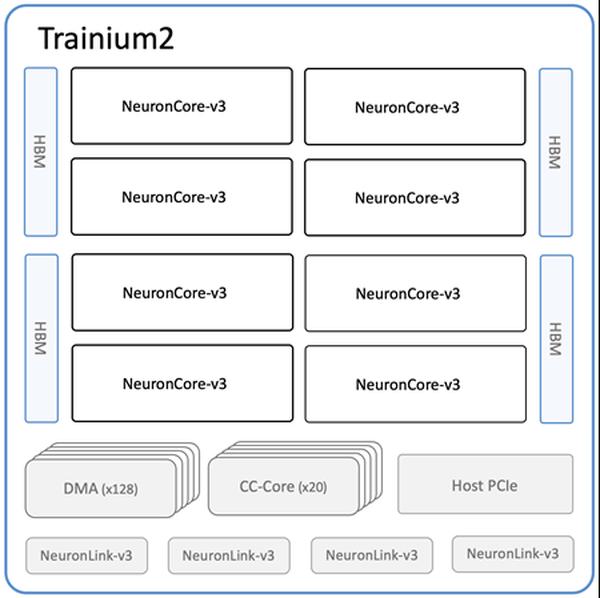

Amazon telah mengumumkan ketersediaan instans Amazon EC2 Trn2 dan Trn2 UltraServers baru, opsi komputasi EC2 terkuatnya untuk pelatihan dan inferensi pembelajaran mesin (ML). Didukung oleh generasi kedua chip AWS Trainium (AWS Trainium2), instans Trn2 4x lebih cepat, memiliki bandwidth memori 4x lebih banyak, dan kapasitas memori 3x lebih banyak daripada instans Trn1 generasi pertama. Instans ini menawarkan kinerja harga 30-40% lebih baik daripada instans EC2 P5e dan P5en berbasis GPU generasi saat ini. Setiap instans Trn2 dilengkapi dengan 16 chip Trainium2, 192 vCPU, memori 2 TiB, dan bandwidth jaringan Elastic Fabric Adapter (EFA) v3 3,2 Tbps dengan latensi hingga 50% lebih rendah. Trn2 UltraServers, sebuah penawaran baru, dilengkapi dengan 64 chip Trainium2 yang terhubung dengan interkoneksi NeuronLink bandwidth tinggi dan latensi rendah, untuk kinerja puncak pada model fondasi terdepan. Puluhan ribu chip Trainium telah mendukung layanan Amazon dan AWS. Lebih dari 80.000 chip AWS Inferentia dan Trainium1 mendukung asisten belanja Rufus pada Prime Day. Chip Trainium2 mendukung versi model Llama 3.1 405B dan Claude 3.5 Haiku yang dioptimalkan untuk latensi di Amazon Bedrock. Instans Trn2 tersedia di wilayah US East (Ohio) dan dapat dipesan menggunakan Amazon EC2 Capacity Blocks untuk ML. Pengembang dapat menggunakan AWS Deep Learning AMI, yang telah dikonfigurasi sebelumnya dengan framework seperti PyTorch dan JAX. Aplikasi AWS Neuron SDK yang ada dapat dikompilasi ulang untuk Trn2. SDK terintegrasi dengan JAX, PyTorch, dan pustaka seperti Hugging Face, PyTorch Lightning, dan NeMo. Neuron menyertakan optimasi untuk pelatihan dan inferensi terdistribusi dengan NxD Training dan NxD Inference, dan mendukung OpenXLA, yang memungkinkan pengembang PyTorch/XLA dan JAX untuk memanfaatkan optimasi kompiler Neuron.

Instans Amazon EC2 Trn2 dan Trn2 UltraServers Kini Tersedia untuk Pelatihan dan Inferensi AI/ML

AWS