Meta telah merilis model Llama 3.2, keluarga model bahasa yang inovatif dengan kemampuan yang disempurnakan, penerapan yang lebih luas, dan dukungan gambar multimodal, sekarang tersedia di Amazon Bedrock. Rilis ini menunjukkan kemajuan signifikan dalam model bahasa besar (LLM), yang menawarkan kemampuan yang disempurnakan dan penerapan yang lebih luas di berbagai kasus penggunaan.

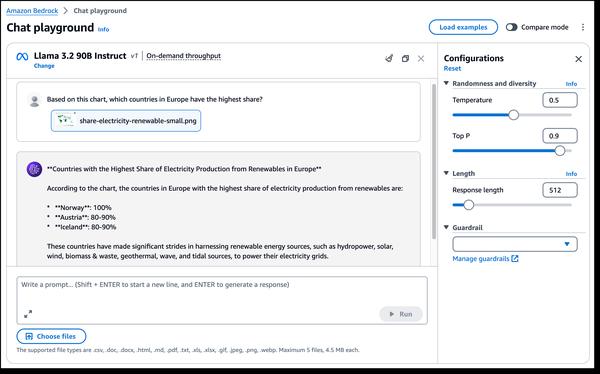

Salah satu aspek yang paling menarik dari Llama 3.2 adalah diperkenalkannya kemampuan visi multimodal. Model 90B dan 11B yang baru dirancang untuk pemahaman gambar dan penalaran visual, membuka kemungkinan baru untuk aplikasi seperti pembuatan teks gambar, pengambilan gambar-teks, dan tanya jawab visual. Kemampuan ini dapat merevolusi cara kita berinteraksi dengan dan memanfaatkan gambar di berbagai domain.

Selain itu, Llama 3.2 menawarkan model ringan yang cocok untuk perangkat edge. Model 1B dan 3B dirancang agar hemat sumber daya dengan latensi yang dikurangi dan kinerja yang ditingkatkan, menjadikannya ideal untuk aplikasi pada perangkat dengan kemampuan terbatas. Hal ini dapat menyebabkan pengembangan asisten penulisan berbasis AI yang lebih cerdas dan aplikasi layanan pelanggan pada perangkat seluler.

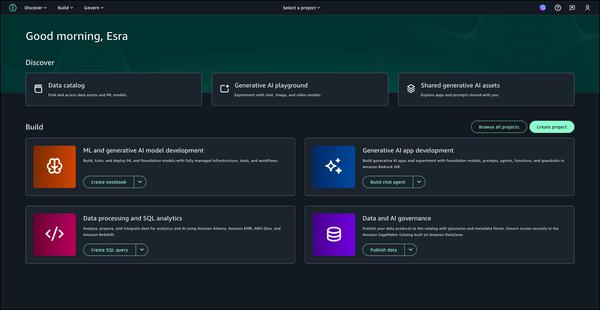

Lebih lanjut, Llama 3.2 dibangun di atas Llama Stack, antarmuka standar untuk membangun komponen rantai alat kanonik dan aplikasi agensi, yang membuat pembangunan dan penerapan lebih mudah dari sebelumnya. Hal ini memberi pengembang cara yang standar dan efisien untuk mengintegrasikan model Llama ke dalam aplikasi mereka.

Secara keseluruhan, rilis Llama 3.2 menandai langkah maju yang signifikan di bidang model bahasa besar. Kemampuannya yang disempurnakan dan penerapannya yang lebih luas membuka kemungkinan baru untuk berbagai macam kasus penggunaan, mulai dari pemahaman gambar dan penalaran visual hingga aplikasi edge. Seiring dengan terus berkembangnya teknologi AI generatif, kita dapat mengharapkan lebih banyak inovasi dan aplikasi transformatif dari model seperti Llama 3.2.